들어가며

우리는 매일 스마트폰과 컴퓨터, 다양한 디스플레이를 통해 세상과 연결된다. 가상현실VR, 증강현실AR 기기는 더 이상 먼 미래 기술이 아니라, 게임과 교육, 의료 현장에서 점점 익숙해지고 있다. 이러한 첨단 기술의 공통점은 인간의 시각을 중심으로 정보를 제공한다는 사실이다. 그런데 우리의 뇌는 수백만 년에 걸쳐 진화해 왔고, 이 과정에서 획득한 시각 처리 방식은 현대 디지털 환경과 완벽히 일치하지 않는다.

그럼에도 불구하고 우리는 놀라울 정도로 빠르게 새로운 시각 환경에 적응하고, 때로는 예상치 못한 부작용을 겪기도 한다. 오늘날의 뇌과학은 이 적응이 단순한 수동 반응이 아니라, 뇌가 병렬적으로 분산된 정보를 통합하고 예측을 조정하는 능동적 과정임을 보여주고 있다.

이 글에서는 뇌의 시각 시스템이 세상을 어떻게 받아들이고 재구성하는지, 그리고 이러한 뇌의 능동적 특성이 우리의 일상 생활과 행동에 어떻게 나타나는지 간단히 살펴보고자 한다.

감각으로 시작하는 하루, 뇌는 어떻게 세상과 만나는가

아침 햇살이 눈꺼풀을 비집고 들어온다. 커피가 추출되는 소리, 고소한 향기, 스마트폰 알림의 진동. 우리는 잠에서 깨는 순간부터 감각 자극에 둘러싸인다. 눈으로 보고, 냄새를 맡고, 소리를 듣고, 몸으로 느끼며 뇌는 끊임없이 외부 세계와 접촉한다.

오감을 이용한 세상에 대한 정보 수집은 우리와 같은 생명체가 세상과 상호 작용하는 첫 단계이다. 각 감각은 우리가 살아가는 물리적인 세상에 대해 다양한 측면을 알려주며, 이 중요하고도 방대한 정보 처리에 우리의 뇌는 많은 부분을 할당하고 있다. 뇌에 있는 신경 세포들은 전기적인 신호로 통신을 하기에 이러한 물리적인 세상의 정보들은 전기적인 신호로 전환되어야 한다. 마치 글자를 모르스 부호로 번역하는 것과 같은 이러한 코딩이 바로 감각 정보 처리의 첫 단계이며, 이는 우리 몸의 각 부분에 위치한 다양한 감각기sensory organs의 작용으로 일어난다. 피부에 있는 수용체들이 물리적인 압력 신호를, 코와 혀에 있는 수용체들이 화학 물질을, 귀 안 쪽에 있는 유모세포hair cells가 소리(공기 파동의 주파수와 크기)를, 눈의 뒤쪽에 위치한 망막이 빛(광학 신호)을 흡수해 색과 밝기 정보를 전기신호로 바꾼다.

감각기에서 전기적 신호로 변환된 신호는 뇌의 여러 영역의 신경세포를 거치며 처리되고, 신경세포의 연결을 통해 엿볼 수 있는 근본적인 정보 처리의 원리는 시각, 청각, 촉각 등 다양한 감각에서 공통적으로 나타난다. 대부분의 감각 정보 처리 경로는 1차 감각 피질에서부터 점차 복잡한 고차 피질로 정보가 전달되고, 이 과정에서 각 영역은 감각 자극의 특정한 측면feature을 분석한다. 일종의 전문가 집단인 각 영역들은 병렬적이고 위계적으로 연결되어 있으며, 이렇게 연결된 회로 혹은 신경망은 물리적인 세상의 여러 측면을 동시에 분석한다.

시각: 영장류 진화의 핵심 동력이자 인공지능의 길잡이

시각은 우리의 여러 감각 중에서도 가장 압도적인 감각이다. 우리는 보는 것을 중심으로 세상을 이해하고 행동한다. 실제로 인간 대뇌피질의 약 30% 이상이 시각 정보 처리에 관여하며, 이는 다른 어떤 단일 감각보다 훨씬 큰 비율이다[1, 2]. 디지털 디바이스와 가상현실 기술이 발달한 지금, 시각은 단순한 감각을 넘어 정보의 주된 통로이자 기술과 인간 사이의 인터페이스 역할을 하고 있다.

아침에 눈을 뜨자마자 핸드폰부터 확인하는 현대인의 하루는 말할 것도 없지만, 사실 디지털 환경으로 가득 차기 전에도 우리의 많은 행동은 시각에 의존해 왔다. 인간이 시각에 강하게 의존하는 것은 우연이 아니며 이는 오랜 시간에 걸친 눈과 뇌의 진화의 산물이다. 초기 영장류 화석을 분석해보면, 안와orbit의 수렴, 즉 눈이 정면으로 모이는 변화가 영장류 진화의 핵심적인 특징이었음을 알 수 있다[3]. 정면으로 배치된 두 눈은 입체시를 가능하게 하고, 발달한 입체시는 곧 복잡한 3차원 환경에서의 정교한 거리 측정을 통한 시각 중심 전략의 기반이 되었다. Cartmill [4]의 시각 포식 가설visual predation hypothesis에 따르면 이는 곤충과 같은 먹이를 정확하게 포착하기 위한 시각 중심의 포식 전략의 결과이다. 망막의 중심부 시야는 고해상도 이미지 인코딩이 가능하도록 세포들이 분포되어 있는데, 이와 함께 이미지를 중심부 시야에 위치시키기 위해 눈을 움직이는 근육이 발달하고, 눈을 움직여 상세한 시각 정보를 습득할 수 있게 되면서 몸을 움직이지 않고도 다양한 관찰이 가능하게 되었다. 삼색각trichromacy을 통해 붉은 색 계통을 볼 수 있어 과일이나 음식물, 그리고 혈색 변화 등을 구분하는 데에 유리해졌다[5, 6]. 이러한 눈의 진화와 그에 따른 시각적 전문화는 관련 뇌 영역의 진화를 동반했다. 영장류는 다른 포유류 그룹에 비해 뇌에서 시각 정보 처리에 할애되는 영역이 상대적으로 큰 반면, 후각 처리 영역은 축소된 경향을 보인다[7]. 또한 영장류 내에서도 시각적 생활상(예를 들어 주행성인지 야행성인지, 또는 과식성인지 엽식성인지)에 따른 시각적 전문화 수준과 관련 뇌 영역의 크기 사이에 유의미한 상관관계가 있음이 밝혀졌다[8].

이처럼 인간을 포함한 영장류는 진화적으로 시각 중심의 전략을 택했고, 원숭이의 시각 시스템은 인간의 그것과 구조적, 기능적으로 놀라울 정도로 유사하다. 이에 따라 지난 몇 십년간 신경과학자들은 원숭이 모델을 이용하여 시각 정보처리 경로 상의 각 영역의 전문성을 상세히 연구해 왔다. 눈 뒤편에 자리 잡은 망막은 빛(광학 신호)을 전기적 신호로 전환하는 감각기관으로 시각 정보처리의 첫 단계이다. 여기서 원추세포(원뿔세포cone cell)가 색을, 간상세포(막대세포rod cell)가 명암을 처리해, 외부 세계의 ‘픽셀’에 담긴 정보를 초벌로 채집한다. 망막에서 변환된 신호는 시신경을 타고 뇌의 시상 중계핵인 LGN을 거쳐, 뒤통수 쪽에 있는 초기시각피질(V1)으로 전달된다. V1 단계에서부터 뇌는 단순 전달 이상으로 신호를 분서하고 재조합한다. V1 이후에는 V2, V4, MT 등의 다양한 영역이 색, 형태, 움직임 등을 분업하듯 처리하고, 이 외에도 수많은 병렬 회로를 통해 ‘이것이 무슨 물체이며, 어디에 있는지’ 파악하는 단계까지 진행된다[1].

이렇게 픽셀 정보에 기반하여 이미지의 내용을 인식하고 식별하는 일은 오늘날 우리에게 익숙한 기술이 되었다. 현대 스마트폰에 내재된 여러 알고리즘은 카메라 화면 상에서 내 얼굴의 위치를 실시간으로 찾아내 필터를 적용해 준다. 내 스마트폰 속 사진들을 클라우드에 업로드하면 알고리즘이 이전 사진과 비교하여 이 사진 속 인물이 과거 사진 속 인물과 동일한지 묻는다. 픽셀 정보로부터 물체를 인식하는 문제object recognition는 컴퓨터 비전으로 불리는 공학 분야가 생물학적 시각 시스템의 해결 방법으로부터 많은 영향을 받아 해결해 온 대표적인 문제이다. 최근에는 인공지능 알고리즘의 발달로 공학적·계산적 해결 방식이 급속히 발전하면서, 이런 방식이 생물학적인 뇌에서는 어떻게 구현되고 있는지를 살펴보려는 연구 경향도 더욱 뚜렷해지고 있다. 이렇듯 인공지능과 생물학적 뇌는 기능과 원리가 완전히 일치하지는 않지만 서로 영감을 주고받는 관계이며, 이 분야의 시작에는 시각 시스템이 큰 역할을 하였다.

능동적인 시각 뇌의 현실 인식과 적응

위에서는 단순하게 표현했지만 사실 실제 시각 정보처리 경로는 훨씬 복잡하다. 망막 단계에서부터 이미 여러 특성이 나뉘어서 분석되기 시작하고, 망막을 떠난 신호는 그 즉시 고속도로처럼 갈라진다. 각 영역은 서로 다른 ‘질문’을 담당하며, 정보는 상위로 올라갈수록 점진적으로 융합되고, 그 과정에서 서로 연결된 수많은 신경세포가 활동하며 양방향으로 통신한다. 덕분에 우리는 1초에 30장짜리 영상을 실시간으로 해석하지만, 뇌 입장에서 이는 퍼즐 조각 수백 개를 동시에 던져 받는 셈이다.

하나의 인풋을 분석하는 문제도 제법 복잡하지만, 더 큰 문제는 자연 환경이 멈추어 있지 않다는 데에 있다. 태양 각도, 물체 거리, 배경 밝기가 매 순간 바뀐다. 연구실에서는 종종 ‘색만 바뀌는 작은 점’ 같은 자극을 써서 회로를 조사하지만, 현실의 뇌는 색·모양·깊이가 동시에 요동치는 세계를 처리해야 한다. 움직이는 차 안에서, 사람들로 북적이는 거리에서, 우리는 우리의 눈에 보이는 세상을 이해하는 데에 아무 문제가 없다. 우리의 뇌는 어떻게 분절된 정보를 통합하는 것일까? “병렬로 나뉜 정보가 언제, 어디서, 어떤 원리로 한 장면으로 봉합되는가?”는 시각 정보 처리의 핵심 미해결 문제로 남아 있다. 이는 ‘세상에 대한 우리의 인식이 뇌에서 어떻게 이루어지는가’라는 근원적이고도 어려운 문제와 맞닿아 있다. 우리가 길에서 친구를 알아보고 인사할 때, 친구 얼굴의 여러 측면을 하나하나 따로 인식하는 일은 없기 때문이다.

여기서 중요한 점은, 뇌가 수동적으로 정보를 받아들이는 단순한 ‘감각 수집기’가 아니라는 것이다. 뇌는 해석과 예측, 확인을 반복하는 능동적인 기관이다. 예측 코딩predictive coding 이론에 따르면, 뇌는 미리 세계를 추론하고 예상하며, 실제 입력과의 차이(오차)를 끊임없이 수정한다. 예컨대 어두운 방에서도 익숙한 사물을 알아볼 수 있는 이유는, 어느 정도 사물의 형태와 색을 예측하고 있기 때문이다. 뇌는 ‘보았다 → 인식했다’ 수준에서 끝나는 것이 아니라, 계속해서 외부 환경을 가정하고, 그 가정에 맞지 않는 부분을 찾아내어 보완하거나 무시하기도 한다. 이렇듯 뇌는 단순한 수용을 넘어 해석과 예측을 수행한다.

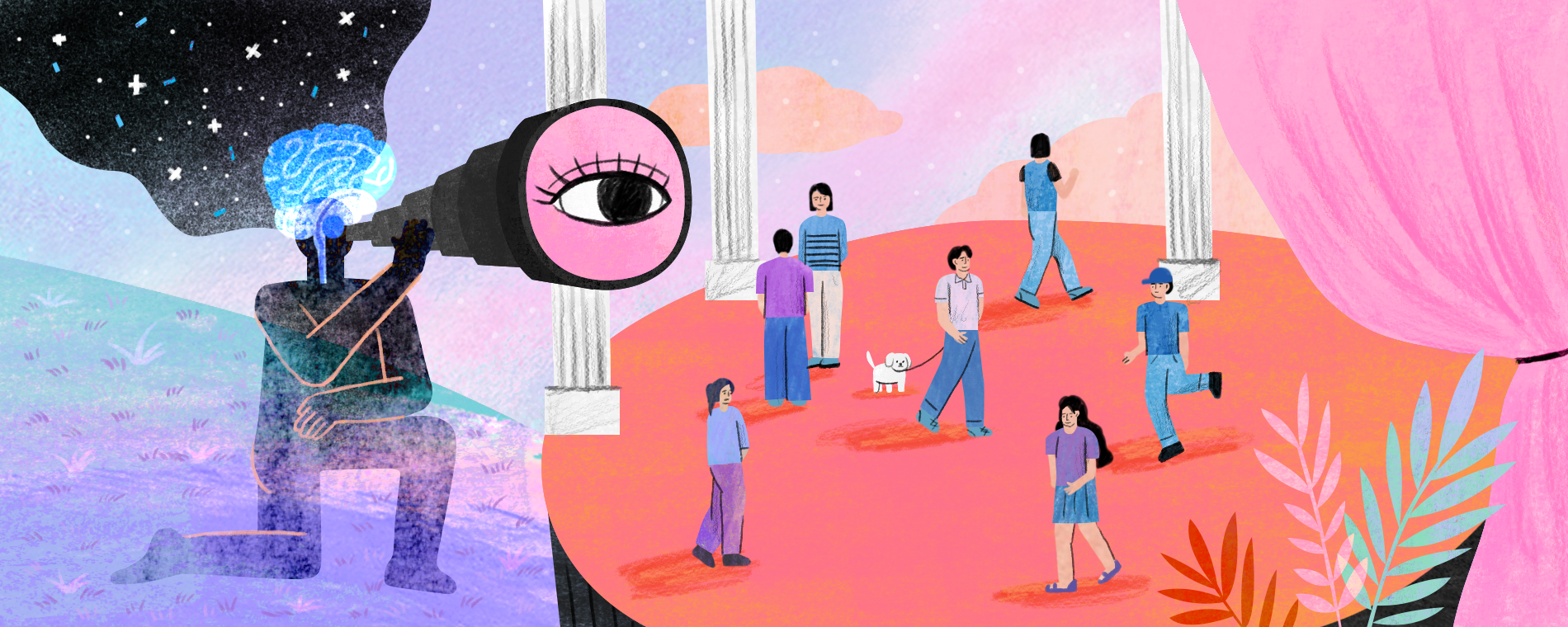

능동적인 시각 시스템을 엿볼 수 있는 대표적인 예는 바로 맥락효과contextual effect이다. 이미지 상에서 물리적으로 같은 크기의 사물, 같은 색깔의 점일지라도 옆에 다른 사물이 놓이는 순간 전혀 다르게 보이기 시작한다. 이는 우리 뇌가 단순히 들어오는 감각 입력을 그대로 분석하는 것이 아니라, 항상 주변 맥락과 함께 정보를 해석하고 재구성한다는 증거이다. 재구성에 영향을 주는 요소에는 실제 인접한 시공간의 외부자극 뿐 아니라, 우리가 경험을 통해 내부적으로 가지고 있는 사물의 크기에 대한 모델도 포함된다. 즉 외부 인풋과 내부 모델이 함께 우리의 현재 인식, 즉 우리의 지각하고 있는 세계의 구성에 참여하는 것이다. 이러한 뇌의 능동적인 해석 과정과 맥락 의존성은 그림 1과 같은 다양한 착시 현상을 통해 쉽게 확인할 수 있다.

능동적인 재구성은 변화하는 환경에 우리가 적응할 수 있는 유연성을 제공한다. 예를 들어 VR 헤드셋의 초보 사용자 중 상당수는 헤드셋을 쓰면 쉽게 어지러움을 느끼거나 멀미 증세를 호소한다. 이는 시각 정보와 신체 감각(전정기관, 고유 수용감각)이 서로 일치하지 않기 때문이다. VR 영상에서는 내가 움직이는 듯한 시각 정보가 들어오지만, 실제 몸은 정지 상태이므로 뇌가 혼란을 일으킨다. 뇌는 ‘눈에 보이는 세계가 실제 신체 움직임과 맞아 떨어져야 한다’고 예측하지만, VR 환경에서는 오차가 커진다. 이 때 뇌는 ‘어딘가 잘못되었다’는 것을 인지하고, 감각 처리에 어려움을 겪게 되는 것이다. 흥미로운 점은, 뇌가 반복 노출을 통해 점차 이 불일치에 적응adaptation한다는 사실이다. VR 게임이나 시뮬레이션 훈련을 자주 하면, 멀미 정도가 점차 줄어드는 경우가 많다. 이는 뇌의 가소성plasticity 덕분이며, 시각 정보와 몸의 감각을 새롭게 맞추는calibration 과정이라고 볼 수 있다.

시각, 감각을 넘어 행동으로

지금까지의 시각 시스템 연구는 뇌의 여러 영역이 어떻게 망막으로 들어온 인풋을 정교하고 효율적으로 분석하는지, 그 분석 원리를 밝히는 데에 초점을 맞추어 왔다. 이를 위해 잘 통제된 시각 자극과 잘 통제된 행동, 그리고 정밀하게 측정된 각 영역의 신경세포 활동이 매우 중요했다. 일례로 지난 수십 년간 시각 시스템 연구는 주된 실험 패러다임은 주로 피험자가 가만히 앉아서 화면의 중앙에 시선을 고정한 채 정교하게 통제된 자극을 보는 방식이 사용되었다. 위에 열거한 시각 영역들을 비롯하여, 지면상의 이유로 이 글에서 언급하지 않은 수많은 시각 영역의 역할은 이렇게 정교한 실험을 통해 밝혀진 것이다. 그러나 시각 시스템을 이미지를 분석하는 기계로 바라보는 이러한 관점은 시각 신경과학이 던지는 질문과 실험 패러다임의 디자인을 하나의 방식으로 고착화시키는 결과도 낳았다[9].

영장류의 시각 시스템이 단순히 사물을 ‘이름표’로 분류하기 위해서 있는 것일까? 시각 정보 처리는 결국 우리 뇌가 더 큰 목표를 달성하기 위한 과정의 일부이다. 포식자를 탐지하면 도망가야 하고, 사회적 시선을 감지하면 표정이나 제스쳐를 준비해야 한다. 즉, 시각 정보는 단순한 인식을 넘어, 빠르고 적절한 행동을 준비하도록 돕는다. 보고 싶던 친구라면 다가가 인사를 건네고, 피하고 싶은 상대라면 고개를 돌린다. 실제로 물체 인식과 물체의 위치를 처리하는 시각 경로는 거기서 그치지 않고 전전두피질, 두정엽, 운동 피질 등 판단이나 행동과 관련된 영역과 연결되어 있다.

최근 신경과학 분야는 측정 기술의 발달로 자유롭게 움직이는 동물에서 수백~수천개의 신경세포의 활동을 실시간으로 추적할 수 있게 되었다. 이러한 기술 발전은 과거 정적인 환경에서 주로 연구되었던 시각 시스템이 실제 행동 중에 어떻게 작동하는지에 대한 근본적인 질문에 답할 실마리를 제공하고 있다. 이제 ‘실제로 행동하는 중 시각 정보 처리’나 ‘행동 중 병렬 정보 통합’ 문제를 정면돌파 할 수 있는 시대가 열린 것이다. 특히, 포유류의 기본적인 시각 처리 원리를 이해하는 데 중요한 단서를 제공하는 쥐 모델 연구에서 놀라운 발견들이 이어지고 있다. 예를 들어 쥐가 단순히 움직이기 시작하는 것만으로도, 이전에는 운동과 거의 무관하다고 여겨졌던 일차 시각 피질(V1) 신경세포들의 반응이 극적으로 증폭되는 현상이 관찰되었다[10]. 이는 시각 정보 처리가 동물의 행동 상태에 따라 얼마나 역동적으로 조절될 수 있는지를 보여주는 중요한 발견이었다. 이러한 발견은 비록 쥐에서의 결과이지만, 인간을 포함한 영장류의 시각 시스템 역시 고정된 상태가 아닌, 능동적인 행동과 밀접하게 연관되어 작동할 것이라는 강력한 시사점을 던져준다. 나아가 최근에는 쥐가 먹이를 사냥하거나, 틈을 뛰어넘기 위해 머리를 까딱이며 거리를 재는 행동을 할 때 시각 시스템이 어떻게 작동하는지를 탐구하는 등, 보다 자연스럽고 복잡한 행동 중에 시각 정보가 어떻게 활용되는지에 대한 연구가 활발히 진행되고 있다[11]. 이와 함께 사람 피험자를 대상으로 한 연구에서도 모바일 EEG, 경량 fNIRS, 걷는 동안 또는 VR 환경 속에서의 안구 운동 추적 등의 새로운 기술이 등장하였다. 이렇게 시각과 행동을 연결시키는 연구들이 진화된 시각 시스템이 과연 어떻게 사용되고 있는지, 능동적인 재구성이 일어나는 구체적인 회로는 어떻게 이루어져 있는지에 대해 새로운 통찰을 제공할 것이다.

마치며: 시각 뇌 연구가 주는 시사점과 미래

우리는 디지털·가상 환경이 일상화된 시대를 살아가고 있으며, 뇌의 시각 처리 방식 역시 이러한 변화에 빠르게 반응하고 있다. VR/AR 기기를 사용할 때 생기는 멀미는 감각 통합의 예측과 오차가 현실과 일치하지 않을 때 나타나는 전형적 사례이다. AI 시각 알고리즘과 실제 뇌의 처리 과정은 서로 닮은 점이 많으며, 덕분에 인공 지능 연구와 뇌 과학이 발전 속도를 함께 끌어올리고 있다.

무엇보다 시각 뇌가 보여주는 가장 흥미로운 점은, 우리가 입력을 단순히 ‘복사’하는 것이 아니라, 끊임없이 미래를 예측하고, 행동을 준비하기 위해 세계를 능동적으로 재구성한다는 사실이다. 앞으로 뇌-기계 인터페이스, 인공 감각 수용기 등 혁신 기술이 등장하면, 뇌와 세상의 상호작용 방식은 더 놀랍게 바뀔 수 있다. 새로운 세대의 디스플레이(홀로그램 등)는 뇌의 적응 과정을 어떻게 바꿀까? 새로운 기술은 이제 단순한 도구가 아니라, 기술을 사용하는 사람의 뇌의 적응성과 재구성 능력을 시험하고 확장하는 무대가 되고 있다. 이 과정에서 시각피질의 구조와 기능 역시, 행동하는 주체의 일부로서 재조명될 것이다. ‘감각적인 뇌’가 급변하는 세상과 어떻게 조화를 이루어 갈지, 그리고 기술이 뇌의 능동성을 어떻게 활용하고 보완할지, 앞으로의 연구가 주목된다.

참고문헌

- Felleman, D.J. and D.C. Van Essen, Distributed hierarchical processing in the primate cerebral cortex. Cereb Cortex, 1991. 1(1): p. 1-47.

- Kandel, E.R., et al., Principles of neural science. Sixth edition. ed. 2021, New York: McGraw Hill. l, 1646 pages.

- Heesy, C.P., Seeing in stereo: The ecology and evolution of primate binocular vision and stereopsis. Evolutionary Anthropology: Issues, News, and Reviews, 2009. 18(1): p. 21-35.

- Cartmill, M., Rethinking primate origins. Science, 1974. 184(4135): p. 436-43.

- Jacobs, G.H., Evolution of colour vision in mammals. Philos Trans R Soc Lond B Biol Sci, 2009. 364(1531): p. 2957-67.

- Surridge, A.K., D. Osorio, and N.I. Mundy, Evolution and selection of trichromatic vision in primates. Trends in Ecology & Evolution, 2003. 18(4): p. 198-205.

- Barton, R.A., A. Purvis, and P.H. Harvey, Evolutionary radiation of visual and olfactory brain systems in primates, bats and insectivores. Philos Trans R Soc Lond B Biol Sci, 1995. 348(1326): p. 381-92.

- Barton, R.A., Visual specialization and brain evolution in primates. Proc Biol Sci, 1998. 265(1409): p. 1933-7.

- Leopold, D.A. and S.H. Park, Studying the visual brain in its natural rhythm. Neuroimage, 2020. 216: p. 116790.

- Niell, C.M. and M.P. Stryker, Modulation of visual responses by behavioral state in mouse visual cortex. Neuron, 2010. 65(4): p. 472-9.

- Skyberg, R.J. and C.M. Niell, Natural visual behavior and active sensing in the mouse. Curr Opin Neurobiol, 2024. 86: p. 102882.